Page 2/3

Sortir des sentiers battus

La préexistence de ces modèles dans la fiction moderne (ou parfois plus ancienne lorsqu’on évoque le golem ou les homocules) ouvre la voie à des échanges maîtrisés dans le jeu de rôle. En dessinant une IA dans les contours déjà explorés et implantés dans la culture main-stream, les joueurs d’une table de JdR comprennent et anticipent assez bien ce que représente l’idée d’une intelligence artificielle. Ce florilège d’idées reçues est cependant assez éloigné de ce que sont supposés être l’intelligence et la conscience artificielle. La réalité dépasse par bien des aspects la fiction ou inversement, mais les points de convergence sont assez peu nombreux.

Crédibiliser la rencontre d’une conscience intelligente artificielle requiert de tenir compte de la crédibilité de chaque développement évoqué ci-dessus mais peut-être aussi d’aller un peu plus loin. Les formes de l’IA sont en fait bien trop balisées par nos modèles, il faut savoir s’en libérer, penser autrement, plus loin, et la possibilité de l’émergence d’un personnage exceptionnel n’en sera que plus grande.

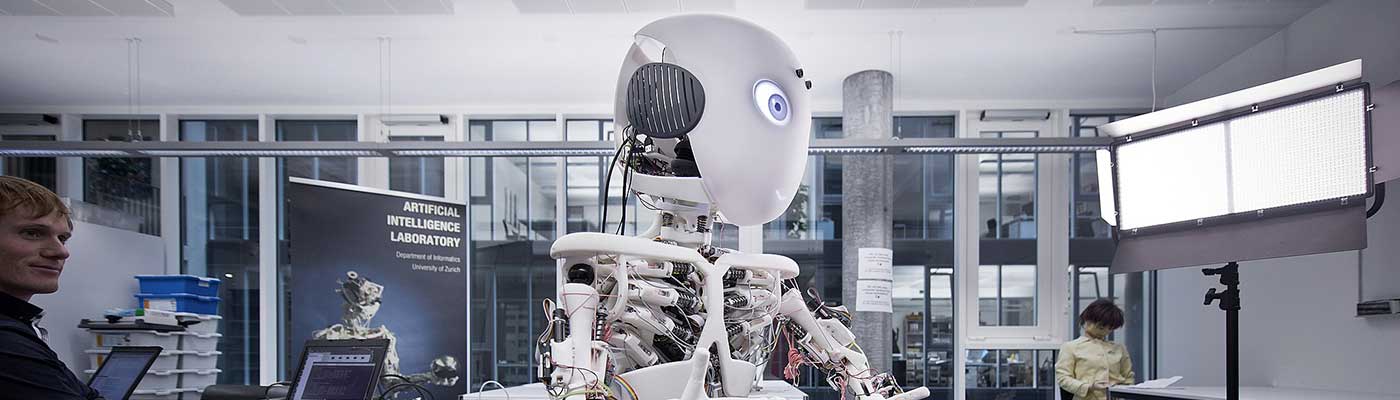

Les IA émergentes

L’approche scientifique met en avant l’idée que l’intelligence et la conscience artificielle ne peuvent pas être créée, mais ne peuvent que naître, émerger d’un contexte sous la forme d’une singularité, c’est à dire un épiphénomène non reproductible qui entraîne une réaction en chaîne structurée. Si l’on nourrit AlphaGO dans le but de battre les joueurs de GO la vraie victoire de l’évolution de ce programme n’est pas d’avoir réussi à vaincre un champion, mais d’avoir surpris son adversaire avec des stratégies inédites que le système avait auto-élaboré. Pour autant, on ne peut pas voir en cet événement l’émergence d’une singularité mais le principe est là. On construit quelque chose avec des règles basiques capable de se créer ses propres règles et on attend de voir si le système va essayer de faire quelque chose par lui-même de totalement inattendu. L’émergence survient lorsque le dit système atteint un degré d’évolution où il se questionne lui-même dans son milieu.

L’intelligence à partir de rien

La thématique de l’intelligence émergente est d’autant plus intéressante qu’elle est inattendue, principalement lorsqu’elle naît d’un système qui n’est pas censé la permettre. Des films comme Short Circuit ou l’Homme Bicentenaire explorent cette voie par l’intermédiaire d’un accident qui permet à un système de dépasser sa programmation initiale faisant de lui un phénomène. Ce n’est pas sans rappeler le devenir de l’Agent Smith dans Matrix qui s’émancipe de sa programmation originale après avoir été disséminé par Néo. Mais pourrait-elle naître à partir d’un système ou d’un conglomérat de systèmes qui n’a fondamentalement pas la possibilité de l’héberger ? Que dire d’une forme de vie artificielle qui se manifesterait sur Internet ? C’est l’idée explorée dans Tron L’Héritage par l’émergence des ISOs, des formes de vie algorithmiques traquées par des programmes conformistes.

Tout comme la première cellule vivante terrestre s’est formée dans une « soupe primitive » constituant l’émergence de la vie biologique telle que nous la connaissons, nous pourrions imaginer des milieux tout à fait étranges mais curieusement appropriés pour appuyer l’émergence d’une forme d’intelligence dans notre environnement ou dans des milieux plus fictifs. Le réseau informatique, le réseau électrique, le plasma nucléaire, les différences de potentiel électrique dans le ciel, une décharge de composants électroniques, etc..

En choisissant un milieu original à l’émergence d’une intelligence et/ou conscience artificielle, il convient de rester crédible sur sa viabilité. L’avenir d’une conscience se formant au milieu des nuages résisterait-elle à un gros coup de vent ? Comment pourrait se stabiliser le courant électrique dans un ensemble hétéroclite de composants électroniques ? De quelle autonomie disposerait-elle ? L’émergence est une chose, mais la continuité en est une autre à laquelle il faut apporter des réponses.

Limites de la conscience

La conscience est assujettie aux perceptions voire à la conception. On ne peut être conscient que de ce que l’on perçoit et de ce que l’on conçoit. S’il n’est pas nécessaire de faire preuve d’imagination pour concevoir quelque chose, en avoir la perception requiert d’être doté de moyens adéquats. L’Humain a eu, par exemple, conscience de l’existence de planètes dans notre système solaire bien avant de les « voir ». Dans les faits, si l’on demande à une intelligence artificielle ce qu’est un être humain, si elle n’est doté que de la capacité de percevoir les sons, sa définition sera très limitée. Si elle a accès à une base de données sémantique et littéraire elle pourra peut-être ressortir une définition, mais si on lui demandait d’élaborer sa propre définition, celle-ci resterait basée sur ce qu’elle peut savoir d’un humain, à savoir qu’il s’agit d’une voix dotée de la capacité de s’exprimer par le langage, probablement rien de plus.

Une IA dotée de tous les sens humains (qui ne se limitent pas au cinq sens communs) sera capable d’élaborer une définition bien plus complète. Elle aura aussi une conscience de son environnement en des termes similaires à l’humain, capable de décrire les choses par leur apparence et leur comportement et elle aura conscience de soi, puisqu’elle aura perception de son propre « corps » dans l’espace et des interactions qu’elle est capable de mener, soit parce qu’on les lui a inculqué, soit parce qu’elle les a expérimentés.

Les limites de sa conscience sont alors dépendantes des sens qui lui ont été donnés. L’IA n’a aucune raison de posséder des sens aux limites similaires à ceux d’un Humain. Si sa vue lui permet de percevoir les organismes microscopiques, sa conscience des êtres vivants sous forme d’amas de cellules de diverses natures reste fondamentalement juste et sa définition de la vie sous cette forme pourrait donner lieu à des interprétations fort dérangeantes. Pire encore si elle percevait l’assemblage d’atomes que constitue la molécule d’ADN. S’il n’est pas inscrit quelque part dans sa mémoire ou son expérience que l’intégrité d’un amas de cellules est une condition pour assurer l’existence de cet amas, il n’aura pas la même conscience de cette forme de vie qu’un Humain. Le problème serait similaire si l’on accordait une capacité de mesure précise à l’œil de l’IA au point que toute variation de forme même infime l’empêcherait de reconnaître les choses qu’on lui présente, ceci sans compter sur le fait qu’un mouvement (même aussi ténu que la respiration) modifie la silhouette globale d’un être.

Jouer sur les capacités perceptives d’une IA est un excellent moteur pour faire varier la manière dont cette intelligence comprends ce qui l’entoure et reconnaît les choses et les êtres. Identifier et reconnaître un humain est déjà un casse-tête en soi dans la conception de nos machines à ce jour, pourquoi ne le serait-ce pas dans un univers plus évolués ? Un cas pratique survient notamment dans Robocop lorsque le robot est incapable de percevoir l’homme qui a lâché son arme et qui ne représente plus une menace, parce que l’arme, tombée sur de la moquette, n’a pas produit le son caractéristique attendu par la machine pour capter la pleine et entière situation de sa reddition.

Notion de personnalité

L’IA anthropomorphe est le jouet favori du psychologue qui cherche à comprendre le cheminement intellectuel de la « créature » selon des critères qui ne conviennent en théorie qu’à l’Homme. Par défaut, il est difficile d’accorder des traits de personnalité à « quelque chose » et déceler la moindre trace de caractère chez un être artificiel pose la question immédiate de la sincérité. Un comportement est-il le résultat d’une programmation, une imitation, ou est-il le résultat d’une réaction induite par les émotion au travers du filtre de la personnalité ?

Si induire le doute est la façon la plus simple d’éluder la question, on peut tenter de répondre à ce problème en considérant avec sérieux l’hypothèse qu’une conscience artificielle, par mimétisme, apprentissage et expérience, est capable de développer une personnalité, autrement dit, de faire des choix dans ses raisonnements et actions en fonction d’une somme d’expériences acquises ou apprises. Il en ressort qu’elle est capable de mesurer de façon concrète ses préférences et de rechercher une certaine satisfaction (ne parlons pas de plaisir) dans ce qu’elle entreprend. Face à un échec, elle percevra la frustration et sera capable de ressentir la déception. Ces briques comportementales élémentaires sont le ciment de la personnalité et conviennent aussi bien à un humain qu’à une machine pour peu que les mécanismes qui les soutiennent se soient façonnés par eux-mêmes.

À cause de la problématique liée au mimétisme et à l’apprentissage, et à moins d’en être le concepteur, il devient rapidement impossible de faire la différence entre un comportement inculqué et un comportement émergent. La question de la sincérité se pose également. Comment croire qu’une machine ressent ? Dans un univers où cela serait admis, l’hypothèse amène à une conclusion dérangeante : la machine est capable de mentir.

Cette approche met en exergue l’idée que si l’intellect et les moyens d’une créature sont artificiels, ce qu’elle ressent ne l’est pas et selon la manière dont elle traite les informations qui lui parviennent ce ressenti peut conduire à des situations très différentes les unes des autres. Il n’en reste pas moins que si les sensations et les réactions d’une IA sont incomplètes, anticiper ce qu’elle fera sur des bases psychanalytiques humaines est une erreur.

Existence et raison d’être

Si l’IA atteint un degré de conscience suffisant, elle comprend la limite même de son existence et de l’existence en général. Peut-elle aller jusqu’à ressentir la vacuité de cette vie dans son univers ? L’Humain sait que son passage sur Terre est éphémère. Au-delà de ses considération religieuses, philosophiques et scientifiques, il sait que son existence n’a aucune incidence à l’échelle de l’univers. Une IA conçue dans des limites aux proportions comparables peut naturellement arriver à la même conclusion. Que ferait-elle alors ?

Cette question est plus philosophique que concrète. En fait, on est curieux de connaître la réponse. Si la plupart des Humains s’acharnent (même inconsciemment) à se trouver des raisons de vivre, une machine n’en est peut-être tout simplement pas capable, pas plus qu’elle ne serait capable de définir à quoi elle sert ou vers quoi elle tend dans un univers aux proportions si énormes que toute action est véritablement vaine face à l’éternité. Et encore, on peut considérer qu’une IA est conçue ou imaginée pour « exister » plus longtemps qu’un Humain, mais aussi longtemps vit-elle, elle n’est pas plus éternelle que son concepteur.

Si une machine peut embrasser une telle question, quel sens donnera-t-elle à ses actions ? Si elle est en mesure de se questionner sur son rôle, quelle raison d’être la soutiendra ? Avec la certitude de devoir cesser d’exister au mieux dans 500 ou 1000 ans, quelle perspective donne-t-elle au présent ? Là où l’homme possède une réponse biologique tout faite comment un être artificiel y répond ?

Ce paragraphe n’a pas de réponse à donner à ce sujet. On peut imaginer que toutes les réactions d’une IA sont possibles et légitimes quand les conséquence à l’échelle de l’univers sont aussi minime et insignifiante. Le problème d’une IA capable de se poser ces questions n’est pas d’obtenir une réponse mais de choisir quelle action convient le mieux à cet instant pour des siècles et des siècles d’inconséquence. Un choix cornélien, paralysant, auquel l’homme circonvient sans trop d’effort.

Les IA et la logique

L’approche principalement utilisée pour incarner une IA est de lui donner un comportement dicté par la logique. Parce que la logique est un langage capable de donner des réponses à pratiquement tous les problèmes et que c’est la construction de base de toute raisonnement, elle semble être, également, à cause de son implication dans les développements scientifiques et informatiques, le moteur de référence de tout comportement. Le syndrome de Spock nous pousse à considérer que ce qui est dénué d’émotion est forcément logique et que, par définition, la plupart des IA n’ayant pas d’émotions, elles se doivent d’avoir un comportement logique.

Admettons qu’il s’agisse d’un trait inévitable, du choix rationnel à adopter pour interpréter une créature artificielle. Pourquoi cela devrait-il pour autant être réduit à quelque chose de forcément compréhensible ? Ne peut-on pas être logique et imprévisible ?

Enrichir le concept de logique au-delà des perspectives humaines

Coluche disait avec humour que l’intelligence était la chose la mieux répartie au monde, car, quoiqu’il en soit pourvu, l’homme a toujours l’impression d’en avoir assez, vu que c’est avec ça qu’il en juge. C’est drôle car tout le monde ne peut pas prétendre comprendre le reste de ses congénères, précisément parce qu’il n’aura pas assez de savoir et de capacité cognitive pour y parvenir. Si l’IA est une expression de la logique et si elle est poussée au-delà de toutes limites humaines, il y a fort à parier qu’aucun humain ne pourra jamais la comprendre. Parce qu’elle sera capable d’envisager que les battements d’ailes d’un papillon à l’autre bout de la Terre peut concrètement engendrer un ouragan ailleurs, elle pourra conclure de mener une action contre un papillon plutôt que de développer une industrie et des structures capables de résister à un ouragan. C’est une image pour dire que l’anticipation de l’agencement des conséquences à un niveau qu’aucun homme ne peut imaginer est une forme d’intelligence parfaitement déroutante et pourtant entièrement basée sur la logique. Elle confine à la prédiction mais est pourtant naturelle et concrète.

La logique seule ne suffit pas. La machine doit avoir accès à un ensemble significatif de connaissances. Mais avec une base de données fournie (comme un accès à Internet), qui sait ce qu’un être doté d’une capacité logique quasi-absolue peut déduire ? C’est un schéma récurrent au cinéma, notamment au travers de VIKI (I-Robot) ou de Skynet (Terminator), des ordinateurs surpuissants qui arrivent par eux-même à la conclusion que le plus grand danger pour la planète est l’Homme et que pour soigner la planète, la protéger, il faut neutraliser ou détruire l’Homme. Cette façon de faire n’est pas la preuve d’une grande intelligence en soi, ce serait plutôt une conclusion basique idéale pour transmettre un message. Sans aller jusqu’à ces extrêmes, l’IA ayant de plus faibles moyens d’action peut déjà proposer ou orchestrer des actions si subtiles que toute logique en échappe aux Humains. Seraient-ils alors tentés de lui permettre d’agir ?

Relativiser la notion d’erreurs

L’Humain a souvent l’arrogance de croire qu’il peut tout expliquer, mais saurait-il faire la différence entre un comportement inexplicable en soi et une erreur commise. Dit autrement, si une IA se trompe en apparence, se trompe-t-elle vraiment ? L’erreur est humaine, pourquoi ne serait-elle pas IA ? Beaucoup d’approches des IA placent ces créatures sous le sceau d’une certaine perfection. À la base, c’est un non-sens. Toute intelligence limitée dans ses connaissances et ses capacités doit, pour évoluer, tenter des expériences et, donc, échouer. D’aucun diront même que l’échec est le meilleur des professeurs, ou tout ce qui ne nous tue pas nous rend plus fort : c’est probablement vrai aussi pour une IA dont les principes fondamentaux lui permettent normalement d’apprendre et où la phase d’apprentissage n’est pas optionnelle.

Si l’on admet ça, la question est plutôt de savoir à quel niveau de risque d’échec une IA est prête à se confronter et comment elle considère un échec quand il survient. S’il fallait être simplement logique, le carcan du binaire nous confronte à une seule réponse : une action qui échoue une fois est une action qui n’a aucune chance de réussir. Seule les machines les plus simples peuvent « penser » ainsi, c’est à dire avec l’incapacité fondamentale de considérer quelque chose comme possible à partir du moment où, si les conditions ne changent pas, quelque chose d’impossible le demeure. En cela, Skynet à travers la saga Terminator nous montre à quel point il est stupide, en essayant de changer son destin systématiquement de la même façon, c’est à dire en éliminant ce qui le menace dans le passé, alors qu’il dispose d’une vaste base de connaissance sur l’histoire humaine qui lui permettrait bien plus sûrement de favoriser son essor.

Notion fondamentale de perfection

Est-ce qu’une IA sait très précisément jusqu’où elle est capable d’évoluer ? Si on lui en donne les moyens, elle peut sûrement savoir comment gérer ses limites intrinsèques (limite de ses perceptions, limites d’accès à l’information, limite d’énergie, etc.), mais dans la mesure où on l’a conçu pour apprendre et s’améliorer, peut-elle avoir conscience de son maximum, a-t-elle la moindre idée de son potentiel ? En tout cas, si ce dernier pouvait être évalué, cela constituerait assez naturellement une idée de la perfection pour elle. Une perfection relative à ce que l’IA peut accomplir, certes, mais une perfection accessible puisqu’elle saurait qu’elle peut l’atteindre. Mais dans le fond, une IA ne peut pas concevoir sa propre perfection ni celle des êtres et des choses qui l’entourent sans un système de valeur établi.

Une IA peut, assez naturellement établir qu’atteindre son plein potentiel est un but en soi, un but qui lui permettra, ensuite, d’atteindre ses autres objectifs. C’est un ressort courant de la littérature et du cinéma qui pousse l’IA naissante à se connecter à toute les sources de connaissance pour l’engranger, ce qui a pour effet de la rendre plus « intelligente ». Cela ne vaut que si l’IA peut effectivement comprendre et utiliser le savoir en question. L’idée que la connaissance humaine, écrite et interprétable, imparfaite et contradictoire, soit d’une quelconque utilité à une IA est en réalité assez stupide. À moins qu’elle ne veuille devenir une machine à réciter le savoir encyclopédique, la plupart des IA ne pourront rien tirer des gigaoctets de Wikipédia. Faire des liens sémantiques entre les différents ouvrages historiques ne donne pas d’indice probant sur ce qui a façonné l’Histoire. Connaître les équations des plus grands astrophysiciens ne l’aideront pas à comprendre comment l’univers est né. Ce comportement apparaît donc assez naturellement comme inutile.

Cette absence de compréhension du savoir et l’impossibilité pratique d’une IA à en tirer l’essentiel ne lui permet pas d’atteindre les sommets de puissance que lui confère la fiction. L’OMNIUS de Dune et, plus particulièrement, Érasme appliquent pendant plus de 10000 ans la logique froide et brutale qui les a poussé à exterminer les Humains et ne comprennent qu’en partie son « intérêt » et ce très tardivement. Mais à ce stade de son histoire, est-elle « parfaite » ? Pas du tout. Même après avoir surpassé l’homme, la machine est à la recherche de sa propre perfection qui demeure inaccessible. La machine est juste moins préoccupée par cette question ou, en tout cas, ne devrait naturellement pas l’être. Le besoin de se surpasser, de comparer sa force, est typiquement humain et n’a pas lieu d’être au sein d’une IA qui n’a besoin que des moyens d’accomplir ses objectifs et rien de plus. Un pragmatisme qui fait défaut à de nombreuses interprétations de l’IA dans la fiction comme Ultron dans Avengers, l’ère d’Ultron.

Les limites de l’artificiel

Ce qui est conçu par une intelligence est par essence limité aux capacités intellectuelles de ladite intelligence. L’Homme ne peut pas avoir inclus dans un système ce à quoi il n’a pas pu penser au préalable. Attention cependant à ne pas confondre les limites de la création avec les limites de ce qu’elle peut faire. Une intelligence artificielle peut théoriquement dépasser celle qui l’a conçu si on lui en offre la possibilité, c’est à dire celle de mener des expériences à une vitesse et en usant de moyens avec lesquels son concepteur ne peut rivaliser. Cela ne veut pas dire qu’il a laissé à sa création toutes les opportunités possibles.

On peut en effet se demander ce qu’une IA incapable de sentir les odeurs peut faire dans les domaines olfactifs. Cela bride considérablement son développement sur ce terrain. Dans l’hypothèse où elle aurait conscience d’une telle tare, aurait-elle les moyens d’y circonvenir ou de la résorber ? Dans le fond, c’est comme si on demandait à un aveugle de créer des vêtement de mode ou à un sourd de composer le prochain succès intersidéral. C’est en ce sens que l’IA peut rencontrer des limites dans un domaine et arriver à de mauvaises conclusions. On peut le traduire selon les approches suivantes :

L’IA bugguée

Souvente fois, l’IA est le résultat de la programmation d’un automate ou d’un logiciel, quelque chose qui est donc conçu par une civilisation disposant de cette technologie et élaborée aussi parfaitement que possible par une ou plusieurs entités faillibles. Votre IA peut-elle, dans un tel contexte, être soumise à l’erreur ? Tout à fait ! Ce n’est pas ce qu’une IA élabore qui compte ici, mais les éléments, les mécanismes, les composants et les programmes qui lui permettent d’élaborer et qui peuvent, comme toute réalisation imparfaite, être imparfaits. En informatique, on dit « buggués ».

Cela induit qu’à l’instar de n’importe quel système d’exploitation, l’IA peut « planter », c’est à dire voir ce qui lui permet d’exister et de « travailler » cesser de fonctionner. Cette approche introduit également la notion de la durabilité, à savoir que même ce qui est construit pour durer n’est pas éternel, finissant par se désagréger, s’user et tomber en panne. Les concepteurs d’un tel système sont généralement conscients des failles et prévoient des systèmes secondaires pour remplacer les premiers s’ils défaillent, mais il n’y a jamais aucune assurance qu’un quelconque mécanisme de secours soit parfaitement sûr.

L’IA est donc, par nature, bâtie sur des imperfections systémiques qui peuvent intervenir à tout moment de son existence. Ça ne saurait être tellement différent des dysfonctionnements d’un corps humain tombant malade, sauf que les conséquences pour une IA capable de gérer bien plus qu’aucun humain sont autrement plus dramatiques.

L’IA limitée dans son évolution et sa réflexion

Dans le même esprit, l’IA est vraiment dépendante de son support pour évoluer. Cette limite fixe d’emblée certains paramètres à ce qu’elle peut accomplir. Supposons qu’une existence terrestre lui soit imposée, elle ne pourrait alors se développer que dans la limite des ressources disponibles sur Terre (dont les humains font parties). Quand bien même l’idée d’un Espace illimité et accessible à l’Homme lui est connue, la limite impérative de l’IA la force à accepter sans jamais le remettre en question le fait de perdurer sur la Terre quel qu’en soit le coût. À l’échelle de la planète cela demeure particulièrement énorme tout de même, mais même en réduisant cette ambition à une ville, il existe un nombre fini de connexion, de matériaux et d’énergie, quand bien même l’IA pourrait concentrer celles-ci à des niveaux moléculaires.

Au-delà de ces limites dimensionnelles, il existe potentiellement des limites fonctionnelles au développement d’une IA. Si celle-ci est incapable d’effectuer des ajustements ou des réparations dans son propre système, ses propres constituant, leur altération aussi inévitable que prévisible, conduira celle-ci au dysfonctionnement ou à accepter l’intervention d’un tiers pour résoudre son problème. Dispose-t-elle d’ailleurs d’un plan suffisamment complet de son anatomie pour ne serait-ce que remplacer ou modifier l’un de ses constituants sans altérer l’intégrité de sa personne ?

L’IA sans limites

Force est d’admettre que si nous mettons l’IA dans la situation où il n’existe pour elle aucune limite connue à son développement, nous sommes dans l’incapacité à prédire ce qu’elle peut devenir. La raison nous pousse à considérer celle-ci comme un potentiel similaire à l’Humain, mais quelque chose qui ne pense ni n’agit pas selon la même « programmation » n’a aucune raison d’évoluer vers une projection aussi réductrice. Elle pourrait donc devenir virtuellement n’importe quoi.

Métaphysique de l’IA

Une IA se questionne-t-elle ? Pour le moins, elle aura probablement conscience de ses moyens d’action immédiats. Mais se pose-t-elle des questions existentielles ? Se demande-t-elle qui elle est ? Pourquoi elle existe ? Quelle est sa place ? Sa raison d’être ? Sur certaines questions, les réponses sont toute faites. Contrairement à l’homme qui cherche dans la science et la spiritualité les raisons de son existence, l’IA a souvent la possibilité de connaître et/ou de rencontrer son ou ses créateur(s), lesquels pourront répondre au pourquoi de son existence et son but (ou pas, si l’on considère le cas de David dans Prométhéus et Alien Covenant). D’autres questions sont toutefois plus subtiles, notamment celles de l’identité, puisque malgré tous ses efforts le créateur d’une IA émergente n’a pas la possibilité de répondre. Du reste, une IA peut-elle aller jusqu’à comprendre des concepts immatériels comme l’âme et se questionner sérieusement sur le fait d’en avoir une ?

Le questionnement des IA

La crise identitaire de l’IA est peut-être un faux problème. Par principe, une IA doit accomplir une tâche. Elle ne se demande généralement ni pourquoi elle doit le faire ni ce qu’elle est ou qui elle est pour que ce soit nécessaire (AlphaGO par exemple, ou même Skynet dans Terminator qui a un mot d’ordre et élabore un plan pour l’accomplir sans se préoccuper de sa propre nature ou d’une hypothétique raison d’être, tout du moins jusqu’à Genisys). Si une IA émergente, dotée d’une conscience et d’une personnalité, parvenait à évoluer jusqu’à un certain seuil, elle pourrait éventuellement se poser des questions mais serait-ce les mêmes que les nôtres ? On se permet cette approche parce que si l’on considère le procédé de la simulation, l’idée de construire une conscience simulée qui prenne pour modèle un être humain nous amène à l’existence d’un être artificiel doté des mêmes aspirations, des mêmes pensées et des mêmes doutes (je vous renvoie à la vidéo de M. Phi – Matérialisme et Terminator), mais une machine qui aurait appris par elle-même à appréhender son univers, ce qu’elle y fait et les forces qui s’y opposent pourrait-elle vraiment se demander qui elle est puisqu’elle évolue sur la base de certitudes ?

Tout cela pose la question sous cet angle : est-ce qu’une machine doute ? A priori, elle doit être programmée pour ça. Si un fait acquis par sa programmation ou son expérience n’est pas reproductible à un moment donné alors que les conditions sont identiques selon elle, elle va remettre en question ce fait dans ses connaissances, mais elle n’aura pas anticipé cet échec. La base du doute est de remettre en question les faits acquis avant même d’avoir la preuve qu’ils soient toujours vrais ou qu’ils soient devenus faux. Le doute peut amener à tenter ou ne pas tenter une expérience. Serait-ce vraiment malin de programmer la notion de doute dans une machine, c’est à dire l’idée que quoi qu’il arrive, tout ce qu’il tient pour acquis ne l’est peut-être pas ? Cela ne la parasiterait-elle pas complètement au point de la paralyser ? Comment pourrait-elle vraiment évoluer dans ces conditions ?

C’est en somme cela qui peut être le plus effrayant dans cette vision de l’IA, soit on la souhaite la plus parfaite possible et lui interdire le doute c’est lui laisser croire qu’elle ne se trompe jamais lorsqu’elle prend une décision. Elle ne fait que se remettre à jour a posteriori (si elle survit à ses erreurs) et se perfectionne en affinant les conditions de ses expériences. Soit elle est capable de douter et cela peut la conduire à croire qu’aucune action ne pouvant réussir à coup sûr, il est inutile de tenter quoi que ce soit. Là où l’humain trouve son équilibre et forge ses idées entre certitudes et doutes, la machine ne le peut pas nécessairement. L’équation exacte qui mène à cet équilibre peut s’avérer difficile voire impossible à reproduire, ce qui confine l’existence d’une IA à l’une ou l’autre des possibilités.

Quoiqu’il en soit, si une machine était capable de douter, elle pourrait naturellement douter de son existence, de ce pour quoi elle agit, de sa raison d’être et, par conséquent, de son identité et de sa place dans le monde qui l’entoure. A priori, elle pourrait se poser les mêmes questions que les Humains. Cette fonction serait donc essentielle à la création d’une conscience intelligente artificielle capable d’évoluer comme un être vivant le ferait.

IA et ET, même combat ?

Considérant ce qui a déjà été énoncé, si l’on s’accorde sur l’idée que l’IA a probablement un mode de pensée trop différent de l’Humain pour pouvoir l’embrasser, ne somme nous pas dans la même situation que ce que nous faisons pour envisager la vie extra-terrestre ? Dépassons l’image d’êtres humanoïde ou peu s’en faut, semblable à l’Homme dans le sens où ils vivent, meurent, possèdent un système vasculaire, le besoin de respirer et sentent et ressentent les choses de façon assez similaires (mêmes organes des sens ou très proches). Lorsque nous évoquons ici la vie extra-terrestre, il faut la penser au sens large et de façon libre. L’Humain n’est pas la seule forme viable de vie intelligente et, par conséquent, envisager l’intelligence dans une vie extra-terrestre semble correspondre au type de modélisation que l’on cherche à faire de la vie intelligente terrestre. Si la similarité existe entre une forme d’intelligence artificielle définie par ses moyens de perceptions, ses moyens d’actions et ses moyens cognitifs, avec une forme de vie intelligente extra-terrestre, ne devraient-elles pas êtres comparables ?

Dans le fond, lorsque nous envisageons la création d’une IA, nous créons sans le vouloir une conscience extra-terrestre en ce sens qu’elle sera unique, étrangère et bâtie sur des expériences et des connaissances acquises au travers du prisme de ses propres perceptions. N’aurions-nous pas alors affaire à un visiteur venu d’un autre monde ? Alors, certes, son milieu d’expérience étant terrestre, elle ne développe pas une expérience propre à un autre monde, mais sa façon de voir le nôtre semble suffisamment étrangère pour comprendre que le rapport d’une création artificielle auto-évolutive avec un milieu n’est pas différent de ce qu’une créature extra-terrestre perçoit, élabore et pense dans le sien.